Más cerca de la lectura del pensamiento

Aquello que vemos, aquello que imaginamos, nuestros más inquietantes secretos o nuestros profundos deseos son, en última instancia, actividad neuronal en nuestros cerebros. Todo eso nos conforma como personas y su administración hacia el exterior crea la imagen de nosotros mismos. El encierro de nuestros pensamientos, sentimientos y emociones en nuestra mente nos da libertad, un lugar acogedor en donde descansar nuestro yo, pero por otro lado una buena dosis de soledad. Si de alguna manera pudiéramos ver los pensamientos de los demás muchas de estas cosas cambiarían. Generaciones de charlatanes han presumido, sin demostrarlo, de poder ver los pensamientos de los demás, ahora quizás estemos cerca de ese objetivo gracias a la neurociencia moderna, que permite estudiar en directo esa actividad neuronal.

Aquello que vemos, aquello que imaginamos, nuestros más inquietantes secretos o nuestros profundos deseos son, en última instancia, actividad neuronal en nuestros cerebros. Todo eso nos conforma como personas y su administración hacia el exterior crea la imagen de nosotros mismos. El encierro de nuestros pensamientos, sentimientos y emociones en nuestra mente nos da libertad, un lugar acogedor en donde descansar nuestro yo, pero por otro lado una buena dosis de soledad. Si de alguna manera pudiéramos ver los pensamientos de los demás muchas de estas cosas cambiarían. Generaciones de charlatanes han presumido, sin demostrarlo, de poder ver los pensamientos de los demás, ahora quizás estemos cerca de ese objetivo gracias a la neurociencia moderna, que permite estudiar en directo esa actividad neuronal.

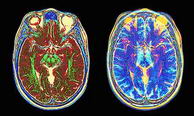

Un grupo de científicos de la universidad de Berkeley acaba de publicar un estudio que demuestra, que gracias al uso de unos algoritmos matemáticos especiales, se podrá (en un futuro no muy lejano) traducir a imágenes la actividad cerebral de las personas y así poder ver lo que otros ven.

En concreto, gracias a su método, ya pueden descodificar los patrones de actividad de las regiones cerebrales responsables de la visión y determinar qué está viendo la persona.

Como parte positiva de este resultado estaría la posibilidad de estudiar la percepción de manera comparada entre distintos individuos, estudiar procesos mentales como la atención y quizás acceder a los contenidos de fenómenos mentales como los sueños y la imaginación.

En los intentos previos de extraer los contenidos mentales a partir de la actividad cerebral medida mediante resonancia magnética nuclear funcional sólo se conseguía decodificar un número finito de patrones. Eran métodos limitados en los que se pedía a los voluntarios visualizar un objeto concreto (un martillo por ejemplo) y se alimentaba al sistema informático con el patrón de actividad generado. Después se podía reconocer ese mismo patrón cuando el individuo pensaba en ese objeto de nuevo. Este método tenía el problema de tener que alimentarse previamente con un número infinito de imágenes si se deseaba reconocer todas las imágenes posibles a posteriori.

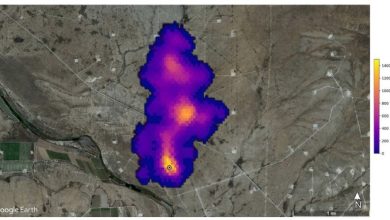

El nuevo método permite, gracias a un modelo matemático, capturar las propiedades de la actividad visual del cerebro y reconocer imágenes mentales que no se han introducido previamente como datos en el sistema. El método parte de la información proporcionada por un sistema de imagen por resonancia magnética nuclear funcional, que mide la actividad cerebral. Dicha actividad es dividida en "píxeles cúbicos" o voxels para su estudio, y se observa la respuesta de cada voxel al estímulo suministrado. De este modo pueden ver qué voxels responden con un patrón determinado como, por ejemplo, al color de la parte superior izquierda de la foto mostrada, mientras que otros voxels responden a otra región de la foto.

El método parte de la información proporcionada por un sistema de imagen por resonancia magnética nuclear funcional, que mide la actividad cerebral. Dicha actividad es dividida en "píxeles cúbicos" o voxels para su estudio, y se observa la respuesta de cada voxel al estímulo suministrado. De este modo pueden ver qué voxels responden con un patrón determinado como, por ejemplo, al color de la parte superior izquierda de la foto mostrada, mientras que otros voxels responden a otra región de la foto.

Luego, en teoría, se puede "interpolar hacia atrás" e inferir qué es lo está viendo la persona en otro momento mediante la monitorización de su actividad cerebral.

Una vez adiestrado el sistema, a los voluntarios participantes en el experimento se les mostró un nuevo conjunto de 120 fotos con toda clase de motivos, como casas, frutas, objetos, personas o animales y el programa pudo identificar lo que veían en un 92% de las ocasiones. Cuando se aumentó a 1000 fotografías el éxito bajó a un 80%.

La precisión del sistema disminuye según aumenta el número de fotografías. Para todas las imágenes indexadas por Google los investigadores calculan que el sistema tendría un éxito de un 10%, pero Google indexa muchas fotos y un 10% está muy por encima de lo que se acertaría al azar en ese caso.

El problema en la precisión parece deberse a la gran cantidad de estímulos a los que están sometidos los individuos. Éstos producen una actividad cerebral extra equivalente a un "ruido" para los fines perseguidos. La localización espacial de un sonido o la información corporal o motora, también tiene consecuencias espaciales, e introducen parte de este "ruido" en las regiones encargadas de procesar las imágenes.

El sistema sería aún más difícil de aplicar a las emociones, intenciones y recuerdos por no estar sujetos a un modelo matemático claro. Los pensamientos abstractos más elevados están también a salvo de este escrutinio.

Así qué no hace falta que de momento se ponga un casco hecho de papel de aluminio, estos algoritmos no pueden ver nuestros pensamientos más profundos, al menos de momento.

Fuentes y referencias:

Noticia en Scientific American.

Artículo en Nature (resumen).

Estudio previo en NF.

Foto superior: Just because you're paranoid por -RobW-.

Fuente: neofronteras.com